GRU

# Tag:

- Source/KU_ML2

toc test

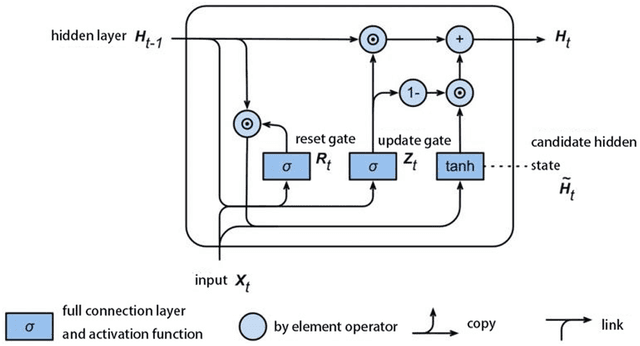

GRU(Gated recurrrent unit)

LSTM의 Cell state가 존재하지 않고, Reset Gate와 Update Gate 두 가지만을 이용한다.

Structure

Gate

Reset Gate

이전의 hidden State에서 지워야 할 부분을 결정한다.

이전 hidden state의 값을 얼마나 활용할 것인지를 결정하는 것으로, 1에 가까울수록 hidden state를 많이 반영하고, 0에 가까울수로 적게 반영한다.

Update Gate

이전 hiddetn State에서 지워야 할 부분이, 새로운 데이터에서 가져와야 할 부분과 유사하다는 점을 이용하여, LSTM의 Input gate와 Forget gate를 통합한다.

- 는 현재의 정보를 얼마나 사용할 지를 반영

- 1에 가까울수록 과거 정보를 지우고 새로운 데이터를 반영

- 0에 가까울수록 과거 정보를 유지하고 새로운 데이터를 미반영

- 는 과거 정보에 대해서 얼마나 사용할 것 인지를 결정.

Comparision with LSTM

- LSTM보다 메모리 차원에서 효율적이다. 따라서 같은 paramerter 수로 hidden state 차원을 더 크게 설정할 수 있다.

- 비슷한 parameter수에 대해 성능 차이는 dataset에 따라 상이하다.